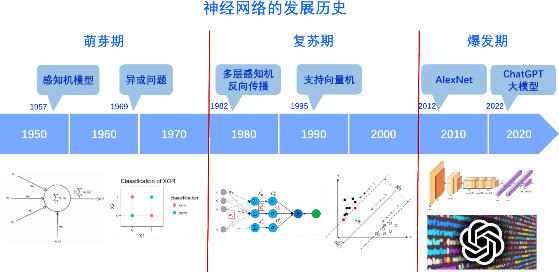

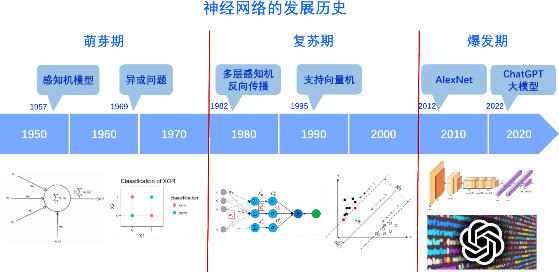

5.1.1 神经网络的发展历史

神经网络作为人工智能领域的重要组成部分,已经在过去几十年中取得了巨大进展。根据关键技术的提出作为时间节点,神经网络的发展历程可划分为以下三个时期:

1.神经网络研究的萌芽及遇冷

早期的神经网络模型受生物学神经元的启发而提出,其中最著名的是 20 世纪 50 年代的感知机模型。感知机模型由两层神经元组成,输入层接收外部输入信号,输出层产生相应的输出。然而,感知机模型的局限性在于只能解决线性可分问题,无法处理非线性问题,甚至无法表示逻辑学中基础的异或关系。受限的表达能力以及当时孱弱的硬件算力使得对神经网络的研究萌芽后不久就进入了寒冬期。

2.神经网络研究的突破及复苏

上世纪 80 年代,多层感知机的提出以及非线性激活函数的引入 极大地增强了神经网络的表达能力,反向传播等理论的提出也为训练 神经网络提供了方法论层面的指导。理论发展的同时也伴随着硬件算 力的提升,此前横亘在神经网络前的表达受限及算力不足显著改善,神经网络真正开始受到广泛关注。尽管关于神经网络的研究已然复苏,但是囿于较小的训练数据集规模,神经网络并没有取得突出的性能表 现,因此人工智能的研究重心仍落在传统的机器学习方法上,例如支 持向量机(SVM)等。

3.神经网络研究的飞速发展

2012 年,基于卷积神经网络(CNN)的 AlexNet 在 ImageNet 比赛中以远超第二名 10 个百分点的优异成绩取得冠军。这样令人震撼的成绩引燃了研究者们研究热情,神经网络开启了爆炸式的发展。一系列的改进和变种模型相继出现,如残差神经网络(ResNet)、循环神

经网络(RNN)和 Transformer 等,这些模型在计算机视觉、自然语言处理和语音识别等领域取得了重大突破。其中,Transformer 因其蕴含较弱的归纳偏置,适用于处理大量的无先验认知的数据,被广泛用作各类预训练模型或是大模型的骨架网络结构,例如语言领域的 Bert模型、图像领域的 ViT 模型和以GPT-4 为代表的大模型。合适的网络结构、大量的数据以及充足的算力,这些条件促成了深层神经网络的诞生,也掀起了人工智能大模型的时代浪潮。

图 5-1 神经网络的发展历史