3.3 数字社会算法裁决过度风险与公平计算

数字经济的核心是数据,大数据、人工智能等技术对经济社会中各种数据广泛和实时的采集和处理,使数据像工业时代的石油一样成为数字经济时代最重要的生产要素。算法是强制给定的有限、抽象、有效和复合的控制结构,在一定的规则下实现特定的目的。随着人工智能技术的广泛使用,一个算法社会正在到来。算法在带动经济增长、提高经济效率、丰富和便利生活的同时,在信息传播、个人隐私、弱势群体利益等方面的负面影响和风险也暴露出来,需要高度重视并加强算法规制。数字社会算法过度裁决造成的负面影响和风险主要包括以下四个方面。

第一,侵害用户隐私。一方面,大多信息的获取没有得到消费者的许可,属于非法采集;另一方面,个人虽然是数据的生产者和所有者,但是这些数据一旦被互联网公司获取后就脱离其最初所有者的控制,个人不但无法知晓自己的信息被用于何处,而且在后续的使用中可能会威胁个人的隐私,甚至可能对个人的财产和人身安全造成损害。

第二,造成算法歧视。在传统的商品市场上,商品的功能和质量高度标准化,价格不同很容易被发现,而互联网服务通常是基于特定时间和特定场景的,时间和场景不同,市场上的供需关系就不同,并由此形成不同的市场价格,这就造成“大数据”杀熟更难被

察觉,也更难被举证。

第三,形成“信息茧房”。人们被算法圈定在“信息茧房”里,被动地接受算法让人们看到的信息。在社会层面,“信息茧房”还会形成用户观点的极化,造成不同群体之间的交流障碍,甚至由于思想的偏狭引致群体间的误会,催生极端行为,引发社会矛盾和冲突。

第四,损害弱势群体。数字经济的发展和算法的广泛使用不会自动地平等惠及每一个人,弱势群体反而会成为算法的受损者。

3.3.1 数字社会算法风险

(1)算法裁决过度风险

2020 年 9 月,自然杂志子刊《机器智能》(Machine Intelligence)刊登了一篇文章《我们赖以生存的算法》,尖锐批评英国政府运用算法预测学生高考成绩,认为用学生平时成绩预测高考成绩是对既有社会分化的固化和极化。人们似乎认为,算法是人类共同面对的、前所未有的敌人,算法之恶已令社会深恶痛绝。为此,如何应对算法的利弊,让算法更好地服务于人类社会?

数字社会的算法与社会的强互动形成算法对生产、生活和治理的实时参与,适合德国社会学家马克斯·韦伯(Max Weber)提出的权力分析框架。在数字社会的算法呈现其社会影响力时,计算社会学权威大卫·拉泽尔(David Lazer)呼吁人们关注算法的影响,并提出“社会算法”(social algorithm),指出计算程序有能力掌握、评估我们的期待并提供个性化的体验。其实这是一种误导,把算法提供的建议当成强制,以为算法掌握了某种社会权力,甚至是霸权。

近些年,随着中美欧出台的算法治理相关法律的落地和算法治理文献数量的爆发式增长,北京大学中国社会与发展研究中心主任

邱泽奇在归纳既有文献基础上,认为数字社会算法过度裁决带来的风险主要有三类。

一是算法风险。在个体层面,算法是强化着“信息茧房”、带来人的认知窄化风险;在市场层面,算法遵循商业逻辑,酝酿着监控资本主义的风险;在国家层面,算法隐藏着被特定利益集团用于社会控制和政治权力再生产的政治风险。

二是算法侵害。现实生产和生活中已经出现了算法歧视、算法偏见、算法共谋、算法垄断、算法黑箱、算法遮蔽、算法短视、算法霸权、算法操纵和算法剥削等与算法关联的侵害,给人类社会生活、经济,甚至政治带来了负面影响。

三是,除算法带来的风险和侵害,还将算法影响上升到制度层面,认为算法权力和算法规则是触发规则竞争、权力竞争,甚至规则垄断、权力垄断的根由。

(2)算法裁决与公平

算法作为数字化时代的产物之一,成为帮助组织快速进行决策及判断的重要工具,被广泛应用于组织管理中。由于算法决策在现实中日益普遍的应用,并对组织和身处其中的成员产生重要影响,研究者们也开始越来越关注成员对算法决策的感知和反应。关于员工对算法的感知,现有文献中存在两种观点。一种是算法欣赏

(algorithm appreciation),认为算法更加高效、准确、客观,人们会更加信任算法决策。另一种则是算法厌恶(algorithm aversion),认为人工决策可以允许员工在决策过程中有更高的参与和控制感,人们会更倾向于选择人工决策。

与这两种观点紧密相关的是算法决策(相对于人工决策)对员

工公平感的影响。近年来,算法决策如何影响员工的公平感也受到关注,但并未呈现一致的研究结果。具体来说,一些研究发现,相对于人工决策,算法决策会带来更高的公平感,因为算法决策具有更高的一致性、无偏性,以及使用的信息更加准确等。然而,另一些研究则发现算法决策未必会导致更高的公平感,因为人们认为算法没有考虑质化信息、不够情境化、无法进行主观评价。这些不一致的研究发现,意味着在决策者类型(算法决策 vs.人工决策)与员工公平感的关系中可能存在重要的调节因素,使得两者的关系在不同情境下呈现出不一样的结果。

探讨这些潜在的调节因素对于我们更全面、具体地理解算法决策对员工公平感及其后续行为的影响非常重要。根据归因理论,员工会对涉及自身的决策进行解释,而这种解释会影响他们对于该决策的反应。特别地,人们面对有利和不利的结果,会进行不同的归因。关于自我服务归因偏差(self-serving attribution bias)的研究发现,当面对有利的决策结果时,员工更倾向于归因于自身因素,因此其公平感较少受外部因素(如决策者特征)的影响。相反,当决策结果不利时,员工更倾向于归因于外部因素,如决策者。此时,由于员工对于算法和人工这两类决策者的无偏性、一致性、准确性等方面有不同的感知会产生不同程度的公平感。因此,基于归因理论,有学者认为决策结果的有利性可能是影响决策者类型与员工整体公平感之间关系的一个重要调节变量。决策者类型与决策有利性的交互作用不仅会影响员工的公平感知,还会影响员工后续的行为结果。其中特别值得关注的是员工的偏差行为。员工在应对算法的过程中表现出的针对组织或社会的偏差行为已经引起了广泛关注。

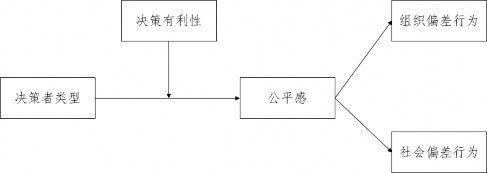

关于公平的研究也发现,当员工感到不公平时,会展现出更多的偏差行为。因此,魏昕等提出了下图 3-2 的研究模型,探讨决策有利性如何调节决策者类型,通过员工公平感对员工偏差行为产生的间接影响。

图 3-2 研究模型

3.3.2 算法公平与公平计算

(1)算法公平

2022 年 8 月 12-14 日,在浙江杭州举行的 CAAI 第七届全国大数据与社会计算学术会议上,中国人民大学信息学院孟小峰教授进行了题为《算法公平与公平计算》的报告,从历史的角度揭示算法公平(AF)的发展过程,并提出从社会偏见、数据偏见和模型偏见三个维度认识算法公平,揭示其相互作用关系。2022 年,马特乌斯-多拉塔(Mateusz Dolata)等在国际信息系统期刊 Information Systems Journal 发表文章 A Sociotechnical View of Algorithmic Fairness(关于算法公平的社会技术观点),其中算法公平被认为是一种新出现的技术,它可以减轻自动决策中的系统性歧视,为改善信息系统(IS)的公平性提供机会。他们基于对 310 篇文章的系统分析,首先对当前关于算法公平的讨论中的基本假设提出了问题;其次,通过将算

法公平理论化为一种社会技术结构来回应这些假设;最后为信息系统研究人员提出了方向,以通过追求独特的对社会技术性算法公平的理解。呼吁并采取全面的办法来处理算法公平。

(2)公平计算

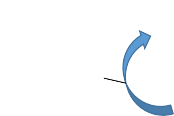

行为偏差

内容产生偏差

孟小峰教授指出,从广义上来看,一切使用算法手段在社会矛盾纠纷中实现公平的方法都可算作算法公平范畴。并将实现广义算法公平的过程称之为“公平计算”(Fairness Computing)。公平计算应该成为算法治理的重要手段,其核心要素包含公平定义与量化、公平监测预警、公平方法权衡等内容。2021 年梅赫拉比(Mehrabi)等发表论文“A Survey on Bias and Fairness in Machine Learning(关于机器学习中的偏见和公平的调查)”,提出了,数据、算法和用户互动反馈回路中的偏差框架(下图 3-3)。

排名偏差

涌现性偏差

聚合偏差

纵向数据缪误