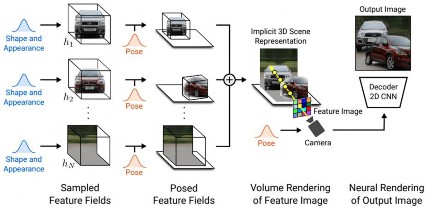

GIRAFFE 通过结合AIGC 与NeRF 的能力,实现了 3D 场景的解耦与可控编辑。具体而言,GIRAFFE 拓展了标准 NeRF 的隐式神经网络表示,对于场景中的每个物体在输入层面加入了代表形状与外观的隐编码,同时将输出中的 RGB 颜色变为了可供后续网络使用的隐式特征。随后 GIRAFFE 讲场景中所有物体输出的隐式特征进行融合,并使用解码器进行体渲染从而得到最终的场景。

图 2-11

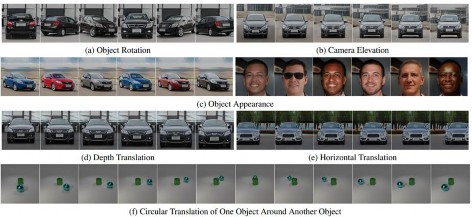

在上述流程中,可以通过改变每个物体的隐编码从而单独控制图像中每一部分的生成内容,从而达到符合用户需求的可控生成的目的。如下图所示,可以分别改变物体的方向、外观或观察的视角而不改变背景内容。

图 2-12