自由度(Degrees of Freedom,简称DF)是一个统计学概念,用于描述数据中独立的信息量。在不同的统计背景下,自由度的定义和解释可能会有所不同,但其核心思想是:在进行统计分析时,有多少数据点是可以自由变动的。

以下是一些常见的自由度的应用和解释:

-

t检验:在进行单样本t检验时,自由度为 ( n - 1 ),其中 ( n ) 是样本大小。这是因为我们使用样本数据来估计总体均值,所以只有 ( n - 1 ) 个数据点可以自由变动,而最后一个数据点是由前 ( n - 1 ) 个数据点确定的。

-

方差分析(ANOVA):在进行单因素方差分析时,总的自由度为 ( n - 1 ),其中 ( n ) 是所有组的总样本大小。组间自由度为 ( k - 1 ),其中 ( k ) 是组的数量,组内自由度为 ( n - k )。

-

卡方检验:在进行 ( R \times C ) 的列联表卡方检验时,自由度为 ( (R - 1) \times (C - 1) ),其中 ( R ) 是行数,( C ) 是列数。

-

回归分析:在进行回归分析时,自由度与模型中的参数数量有关。例如,在简单线性回归中,有一个截距和一个斜率,所以模型有2个参数。如果有 ( n ) 个观测值,那么误差的自由度为 ( n - 2 )。

总的来说,自由度是一个重要的概念,它帮助我们理解数据中的独立信息量,并在许多统计方法中起到关键作用。

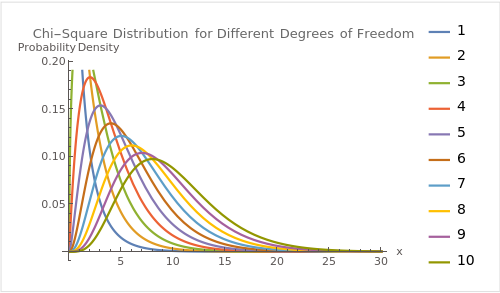

以下是不同自由度的卡方分布的形状:

图中展示了自由度从1到10的卡方分布。随着自由度的增加,分布的峰值向右移动,并且分布变得更加平坦。

图中展示了自由度从1到10的卡方分布。随着自由度的增加,分布的峰值向右移动,并且分布变得更加平坦。